DeepMind 发了篇论文,把我看笑了

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

文 | severus

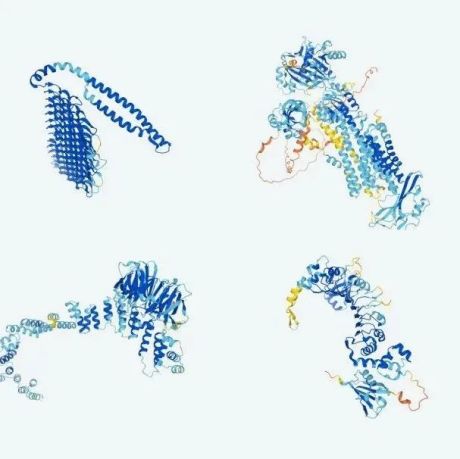

近日,曾开发出举世瞩目的 AlphaGo 的 DeepMind,在 ArXiv 上发表了一篇文章,名为:

Meaning without reference in large language models

文中提到,大参数规模的语言模型是已经具备了部分类人智能的,但由于它们仅仅接受了纯文本数据的训练,所以其能力也没有得到充分的发挥。

文中举出了大量的例子,试图证明 LLMs,或其他以 transformers 为主要结构的大模型,已经具备了和人类表现类似的智能能力。

DeepMind 一直是通用人工智能(AGI)探索路上的先行者,今年上半年,他们也曾提出了 Gato,在604个不同的任务上都取得了不错的表现,大有 AGI 模型之势。

在笔者看来,其至少证明了,当模型的容量足够大的时候,其的确能够容纳 合格地完成不同的窄领域任务 所需的知识,更像是给我们展现了 通用agent 的可行性,但真的说是智能的话,似乎同笔者的认知有所偏差。

论文标题:

Meaning without reference in large language models论文地址:

https://arxiv.org/abs/2208.02957 人的智能表现文章提到,人的某些智能表现一定不是从大数据中得到的。例如:

抽象概念的能力 :在人的知识体系中,存在大量的抽象概念,而这些抽象概念几乎不可能从与世界的交互中得来。如:正义、法律、才智等,并且人可以轻易扩展这类概念。

对事物本身的理解可以脱离载体 :当写有协议的纸张被损坏的时候,协议本身依旧是存在的;当记录法律的书本被遗失的时候,法律本身依旧是生效的。

想象能力 :人能够想象不在眼前的事物,也能够想象世界上不存在的东西,甚至可以去想象一个架空的世界。

逻辑推断能力 :人可以通过已知概念的组合,即可推断出新的概念。如数学证明,理论物理学的发展等。

文章认为,这些能力几乎不可能仅从大数据中得到,人也不可能仅仅通过大数据归纳学习,就具备了这些能力,而(文章认为)大量的例子表明,大模型已经初步具备了上述的能力,所以,当前大模型的结构已经符合了智能。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯