ChatGPT核心方法可用于AI绘画,效果飞升47%,通讯作者:已跳槽OpenAI

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

量子位 | 公众号 QbitAI

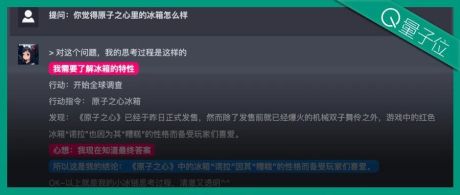

ChatGPT中有这样一个 核心训练方法 ,名叫“ 人类反馈强化学习 (RLHF) ”。 它可以让模型更安全、输出结果更遵循人类意图。 现在,来自谷歌Research和UC伯克利的研究人员发现,将该方法用在 AI绘画 上,“治疗”图像跟输入不完全匹配的情况,效果也奇好—— 可以实现 高达47% 的改进。

△ 左为Stable Diffusion,右为改进后效果

这一刻,AIGC领域中两类大火的模型,似乎找到了某种“共鸣”。

如何将RLHF用于AI绘画?RLHF,全称“Reinforcement Learning from Human Feedback”,是OpenAI和DeepMind于2017年合作开发的一种强化学习技术。 正如其名,RLHF就是用人类对模型输出结果的评价 (即反馈) 来直接优化模型,在LLM中,它可以使得“模型价值观”更符合人类价值观。 而在AI图像生成模型中,它可以让生成图像与文本提示得到充分对齐。 具体而言, 首先,收集人类反馈数据 。 在这里,研究人员一共生成了27000余个“文本图像对”,然后让一些人类来打分。 为了简单起见,文本提示只包括以下四种类别,分别关乎数量、颜色、背景和混合选项;人类的反馈则只分“好”、“坏”与“不知道 (skip) ”。 其次,学习奖励函数。 这一步,就是利用刚刚获得的人类评价组成的数据集,训练出奖励函数,然后用该函数来预测人类对模型输出的满意度 (公式红色部分) 。 这样,模型就知道自己的结果究竟有几分符合文本。 除了奖励函数,作者还提出了一个辅助任务 (公式蓝色部分) 。 也就是当图像生成完成后,模型再给一堆文本,但其中只有一个是原始文本,让奖励模型“自己检查”图像是否跟该文本相匹配。 这种逆向操作可以让效果得到“双重保险” (可以辅助下图中的step2进行理解) 。 最后,就是微调了。 即通过奖励加权最大似然估计 (reward-weighted likelihood maximization)(下公式第一项) ,更新文本-图像生成模型。 为了避免过拟合,作者对预训练数据集上的NLL值 (公式第二项) 进行了最小化。这种做法 类似于InstructionGPT (ChatGPT的“直系前辈”) 。

效果提升47%,但清晰度下滑5% 如下一系列效果所示,相比原始的Stable Diffusion,用RLHF微调过后的模型可以: (1)更正确地get文本里的“两只”和“绿色”; (2)不会忽略“大海”作为背景的要求; (3)想要红老虎,能给出“更红”的结果。

从具体数据来看,微调后的模型人类满意度为50%,相比原来的模型 (3%) ,得到了47%的提高。 不过,代价是失去了5%的图像清晰度。 从下图我们也能很清楚的看到,右边的狼明显比左边的糊一些: 对此,作者表示,使用更大的人类评价数据集和更好的优化 (RL) 方法,可以改善这种情况。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯