DeepMind 发了篇论文,把我看笑了(5)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

人学会进行这么大规模的归纳,实际上是低能耗的,但是大模型则不然,想要训练一个百亿级别参数的模型,其耗费的资源是相当巨额的,恐怕会超过一个人从出生到成长为领域专家所耗费的所有资源。

但是笔者认为,这篇文章提到的一些例子,倒是还有一些其他的价值,比如:

已被模型抽象过的表示,其上层映射起来的确更加简单,如颜色的那个例子,或许这方面工作的拓展,可以对多模态模型提供指导经验,例如 Google 今年的 imagen,用大规模语言模型训练,抽象了语义之后再去指导图片生成,就是一篇不错的尝试

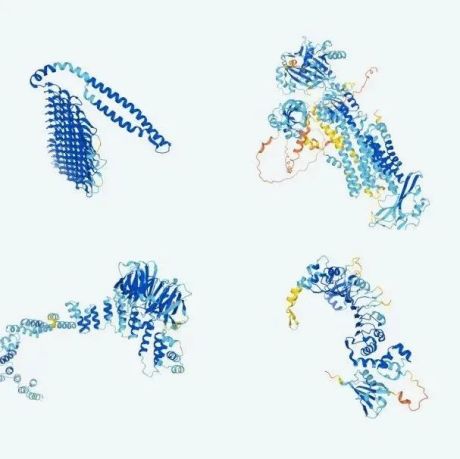

现有的统计模型,及其对应的归纳学习机制,的确部分实现了对大部分基本概念的学习,尤其是增加了多模感知信号之后,那么跳出现有框架,探索新的机制或许更加可行

总结:DeepMind 想干什么笔者认为,DeepMind 的科学家们一定比笔者厉害得多,它们不可能不知道,这篇文章预设的结论有多么不合理,找到的证据又有多么无力,但是它们为什么要发表呢?

答案是, 这篇文章应该不是写给内行看的,而是写给外行看的。

哪怕行内人对当前人工智能的现状是什么样的认知,但是几个简简单单的例子,足够震慑到外行人了,而相比于从业者,其他人显然是更多的,那么只要将这些东西放出来,就足以吸引很多人的眼球,那么这个行业的热度就维持住了。

说这么多,也只是希望,从业者,以及想要从业的同学们,别也被这篇文章唬住了,或者被各路大模型的 PR 唬住了,脚踏实地一些,或做出真东西,或探索新套路。

最后,类人也不应该是 AI 的目标,如果 AI 真的类人了,人类又将如何自处?人类想要的也无非是更廉价、更专业、工作时间更长,且不需要为之安全有多负责的助手,而非另一个竞争者。

毕竟,1(数)2(百)年前,人类在潘(新)多(大)拉(陆)星球上,面对从未见过的人类时,都已痛下杀手,又怎会允许现在的人们,造出一个或许能超越自己的智能呢?[doge]

以上。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯