MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流(2)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

多语言建模、回译等多管齐下扩充低资源语言数据

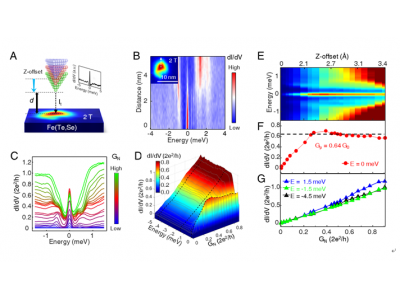

机器翻译的目标是训练一个模型或概率分布,将在给定源句子x的情况下估计目标句y。 训练过程中需要构建句子对(Sentence-pair),即从源语言(Souce Language)到目标语言(Target Language)能够对齐的一对句子。 句子对数据是实现机器翻译模型训练的基石。 但是,能够对齐的双语文本(Bitext)是非常稀缺的,特别是小语种领域。如上图的语种数据量柱形图所示,最右侧代表英语语种的数据量,其有着高质量的翻译文本。仅仅是WMT数据集,就有大约4000万个句子对,研究者已经可以基于这些数据训练大型模型,并实现接近人类质量的翻译。 另一方面,在图表左侧的语言资源较少。在这里,研究者设阈值为100万(对),任何低于 100万对句子的语言都称为低资源语言。在图表中,70%的语言是没有足够的数据来训练双语机器翻译模型的,共148种。这就需要采用一些技术方法,才能在如此低的资源条件下训练。 因此,在NLLB的研究过程中,研究者首先要做的就是扩展已有数据集的规模。他们采用了数据挖掘的方法,主要目标是收集非对齐的单语料数据(Monolingual Data),然后在这些文本之间建立可以翻译的潜在文本对。 数据挖掘流程有两个组成部分:一是语言识别,研究者自行构建了一个语言识别模型(Language Identification,LID),能够对获得的文本进行分类,判断属于哪种语言,如法语、中文、阿拉伯语等。二是构建多语言句子编码器(Multiangle Sentence Encoder),研究者提出了LASER-3模型,其能够将语言编码共同嵌入到一个公共的表示空间中。在这个表示空间中,研究者使用一些相似度搜索的方法,来判断两个句子之间是否是对称相似的。通过这种方法来扩充148种语言所需的翻译数据。 在有了语言识别模型后,研究者通过人类验证的方法迭代提升模型的准确性。研究者爬取了网络的文本数据,并通过语言识别系统来识别文本的语言。在进行数据清洗后,再将文本映射到通用的表示空间中,并进行相似度搜索,直到构建出挖掘后的,可以用于训练的数据为止。同时,研究者基于已有的Bitext数据,通过训练编码器的方式来对挖掘数据进行验证。如果无法训练出一个机器翻译模型,则意味着挖掘的数据质量不佳。 第二种增加训练数据的方法是回译(Back Translation),其方法是训练一个机器翻译模型,但训练目标是让模型根据目标侧的语言来生成源语言。机器翻译模型对于目标侧的数据质量相比源语言侧的更加敏感。当回译获得的数据足够多之后,就可以添加到挖掘数据的顶部。 总体上,团队的数据分为5个部分。其中最为干净的是NLLB-Seed。这些数据不依赖任何模型产生,质量也较高。接着是公共来源的翻译数据(Pblic Bitext),这是通过网络爬虫获得的Bitext,噪声相对较多。研究者只是按照原样使用他们。后三种数据是基于单语料建立的数据,包括用数据挖掘方法获得的翻译数据,以及两种通过回译方法获得的数据,分别采用了神经网络方法和统计机器翻译方法。 在未采用这些方法之前,70%语言的句子对少于100万。但在加上挖掘和回译方法后,大多数语言都超过了100万对,训练数据量提升了两个数量级,甚至有些语言提升了三个数量级 (10^4到10^7) ,这为训练高质量的机器翻译模型奠定基础。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯