MetaAI科学家解读最新模型:200+语言互译,千倍翻译数据,全球元宇宙用户自由交流(4)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

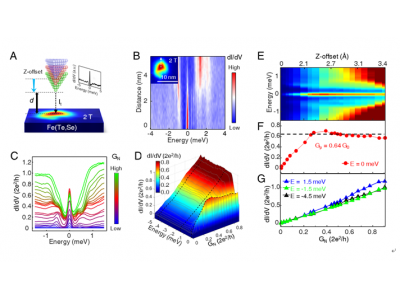

NLLB模型的实际效果如何? 下图中,研究者训练了三种模型:一种是只采用了原始的Bitext数据的模型(蓝色)。第二种是原始数据结合挖掘后的数据(灰色)。而最后一种是原始数据、挖掘数据和回译数据结合的模型(绿色)。 在效果评价方面,研究者根据资源(即原始翻译数据量)来分别评价模型的好坏。超过100万翻译对的是高资源语言,低于100万翻译对但超过100K的是低资源语言,低于100K个翻译对的是极低资源语言。在翻译类型上分为三种,包括从英语到任意语言,从任意语言到英语,以及任意语言之间。评价性能指标使用的是spBELU和chrF++。从下图中可以看到,结合了三种数据训练的模型效果最佳(绿色条带)。 在模型性能对比上,研究者采用了M2M-100、Deepnet和NLLB-200,对87和101种语言的翻译进行了对比,对比数据集采用了FLORES-101。NLLB-200平均性能比最近的SOTA高出了7.3的spBLEU分值。 此外,研究者使用NLLB在自创的FLORES-200数据集上进行了任意语言的互译,并对比了不同资源级别语言的翻译性能。 由于翻译语料来自维基百科,研究者也在WMT等其他的数据集上进行了测试。研究者也在聊天、医疗、新闻和文本四个领域进行了测试,取得了一定的效果。 目前,NLLB模型及相关数据集已经开源,并集成到HuggingFace的模型库中。

NLLB消耗5万多GPU小时,可能在教育、元宇宙等领域应用

在分享后,观众向Elbayad博士进行了提问,智源社区对部分回答进行了节选。Q:NLLB模型消耗的算力是多少?如果要将机器翻译模型部署在移动端等场景上,需要做哪些工作? A:NLLB研究使用的是GPU A100芯片,在训练方面总共花费了5万个GPU小时进行训练,相当于连续训练模型3周的时间。 在论文中已经提到,团队对NLLB模型进行了小型化的研究,如进行蒸馏等。如下图所示,NLLB模型的初始规模为540亿,研究者将其作为教师模型分别蒸馏了13亿参数和6.15亿参数的学生模型(Dense Distilled)。将学生模型和基准进行对比发现,蒸馏后模型的效果依然较好。 Q:NLLB目前有无商业化的规划和想法?可能会在哪些领域得到应用? A: Elbayad博士不掌握商业化方面的信息 ,Meta内部有专门负责商业化的团队进行推动。 对于可能的应用领域,目前NLLB模型可能在教育和公共服务方面有所进展。根据Meta官方博客,NLLB已经可以对儿童书籍进行翻译。可能在儿童教育方面有发展的潜力。 此外,官网也提到了NLLB-200在维基百科、社交软件(如Instagram)上的应用——提供低资源语言的高质量翻译服务。 而Meta也不忘记自己的老本行——元宇宙的发展。在NLLB的加持下,实现全球元宇宙用户的自由交流,似乎也不再是一个过于遥远的目标。 图注:NLLB-200博客介绍的四大应用场景:社交软件、元宇宙、体验式场景(如旅游)和教育。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯