中国的人工智能研究有多强?一起来世界人工智能大会讨论大模型

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

导语

一种迈向通用人工智能的潜在路径正吸引越来越多的关注。

达摩院M6-OFA创作的画作

2017年,一篇仅仅10页的论文,在谷歌学术上被引用了4万多次,而它的核心工作就是提出了基于注意力机制的经典框架Transformer, 该团队也在当时将Transformer概括为一句话——“Attention is All You Need”。

事后看,这个框架确实不负众望,它不但极大推动了人工智能技术的发展,还通过这个发展为其他学科和很多行业的变革创造了难得的机遇,对科学研究新范式的思考都与此密切相关。

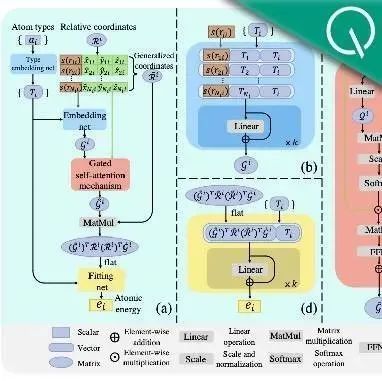

客观来说,这个全新的架构至少在两个方面为人工智能研究带来了巨大的改变。首先,它为 神经网络参数规模的扩大奠定了坚实的基础,从而推动人工智能开辟出一个完全不同的空间, 原本训练效果不佳的无监督学习也因此取得巨大的突破。同时 ,云计算的兴起又搭建出一个更大的舞台,这意味着一个完整的AI模型可以分布在成千上万台服务器上,从而推动大型网络参与训练。

2019年之后那场令人印象深刻的“数据+算力+深度学习”的狂飙突进因此可以预见,因为它能 令 AI的泛化能力 迈上 更高的台阶,打破以往“模型定制 化”的窘境,背负让人工智能从“感知智能”进入“认知智能”的期盼。

2020年5月,OpenAI发布了参数规模高达1750亿的大模型GPT-3,大模型的竞争正式起步; 次年1月,谷歌推出Switch Transformer,参数规模达到1.6万亿; 2021年,达摩院也强势进入这一领域,并在很短的时间内相继推出了语言模型体系AliceMind、多模态大模型M6,在将参数规模提升到10万亿以上的同时,也开始推动对大模型商业落地以及绿色低碳的系统思考。

在这个过程中,很多新的思想和趋势判断不停出现。在去年的《达摩院十大科技趋势》中,达摩院的科学家和来自其他高校的学者们也提出,模型参数的规模竞争也许会告一段落,但围绕大模型与小模型的协同进化等方向的研究方兴未艾,围绕大模型的研究将继续向更加精细的纵深方向发展。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯