薛定谔的 AI 大模型:箱子暂不能打开,但钱还要继续「烧」(4)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

AI 模型一定要越来越大吗?

事实上,针对 AI 模型越来越大的现象,学术界与工业界的部分研究者已经注意到其在落地中的利与弊,并积极展开应对之策。 如果要说科技对社会的改变给予了人们怎样的启示,那么其中一定会谈到的重要一条便是:如何降低科技产品的门槛(无论是技术上还是成本上),让更多的人能够享受到这项科技的好处,才能扩大它的影响力。 换到大模型中,核心矛盾就是如何提升它的训练速度、降低训练的成本,或提出新的架构。 如果单从调用计算资源来看,大模型的窘境实际上并不突出。今年 6 月底开放工程联盟 MLCommons 发布的 MLPerf 基准最新训练结果显示,今年机器学习系统的训练速度几乎是去年的两倍,已经突破了摩尔定律(每18-24个月翻一倍)。 事实上,随着各家服务器的更新迭代,云计算等新颖方式的出现,计算一直在加速,能耗也一直在降低。举个例子,GPT-3 推出仅两年,如今 Meta 参照它所研发的 OPT 模型的计算量已经降低到了2020年的1/7。此外,最近还有一篇文章表明,2018 年需要几千块 GPU 训练的大模型 BERT,如今只需要单卡 24 小时就能训练好,一个普通的实验室也能轻松训练。 获取算力的瓶颈已经不存在,唯一的拦路虎只是获取成本。 除了单纯依靠算力,近年来,也有一些研究者希望另辟蹊径,单从模型与算法本身的特性去实现大模型的「经济可用性」。 一种途径是以数据为中心的「降维」。 最近 DeepMind 就有一项工作(“Training Compute-Optimal Large Language Models”)成功探索发现,在计算量相同的情况下,将模型的训练数据变大,而不是将模型的参数量放大,可以得到比仅仅放大模型更好的效果。 在 DeepMind 的这项研究中,一个充分利用了数据的 700 亿参数模型 Chinchilla 在一系列下游任务的评估中超越了 1750 亿参数的 GPT-3 和 2800 亿参数的 Gopher。蓝振忠解释,Chinchilla 之所以能够取胜,就是因为在训练时将数据扩大、翻倍,然后只计算一遍。 另一种途径是依赖算法与架构的创新,将大模型「轻量化」。 微软亚洲研究院前副院长、现澜舟科技创始人周明是这一赛道的追随者。 作为一名创业者,周明的想法很「本分」,就是要省钱。他指出,如今许多大的公司都在追求大模型,一是争先恐后,二是也想体现自己的计算能力,尤其是云服务的能力。而澜舟科技作为一家诞生不久的小公司,有用 AI 创造价值的梦想,但没有强大的云能力,钱也不够烧,所以周明一开始想的是如何通过模型架构的调整与知识蒸馏等等方式,将大模型变成「轻量化模型」给客户使用。 他们在去年 7 月推出的轻量化模型「孟子」证明了该想法的可行性。「孟子」的参数仅 10 亿,但在中文语言理解评测榜单 CLUE 上的表现却超越参数量级为百亿甚至千亿的BERTSG 与盘古等等大模型(如下表)。领域的一个共识是:在同一个架构下,模型一定是参数量越大、性能越好,但「孟子」的巧妙之处,就在于架构的创新。 在学术界,不久前,加州大学伯克利分校的马毅教授与沈向洋、曹颖还联合发表了一项研究(“On the Principles of Parsimony and Self-Consistency for the Emergence of Intelligence”),从理论上解析了大模型为何越来越大的技术原因,即深度神经网络本质上是一个「开环」的系统,即用于分类的判别模型和用于采样或重放的生成模型的训练在大部分情况下是分开的,导致对参数的训练效率低下,只能依靠堆参数与堆算力来提升模型的性能。 为此,他们提出的「变革」方式更彻底,就是主张将判别模型与生成模型组合在一起,形成一个完整的「压缩」闭环系统,这样 AI 模型就能够自主学习,并且效率更高、更稳定,在面对一个新的环境中可能出现的新问题时,适应性与反应能力也更强。换言之,如果 AI 领域的研究者能够沿着这条路线去开发模型,模型的参数量级会大幅缩小,回归到「小而美」的道路上,也能实现大模型「解决未知问题」的能力。 在实现经济可用上,甚至还有一种声音,是主张通过 AutoML 或 AutoAI 的方式来解决模型训练的难度,降低 AI 算法的研究门槛,让算法工程师或非 AI 从业者可以灵活根据自己的需求来打造单一功能的模型,形成无数个小模型,星星之火、可以燎原。 这种声音是从「需求」的角度出发,反对闭门造车。 举个例子,视觉算法用于识别、检测与定位,其中,识别烟雾与烟火对算法的要求不同,那么他们就提供一个平台或工具,让需求者可以分别快速生成一个识别烟雾与识别烟火的视觉算法,精度更高,也不必追求跨场景的「通用性」或「泛化性」。这时,一个琴棋书画样样精通的大模型,可以分为无数个分别精通琴、棋、书、画的小模型,同样也能解决问题。

99科技网:http://www.99it.com.cn

人工智能驱动的IP保护平台MarqVision完成2000万美元A轮融资,为品牌创建知识产权管理系统

人工智能驱动的IP保护平台MarqVision完成2000万美元A轮融资,为品牌创建知识产权管理系统

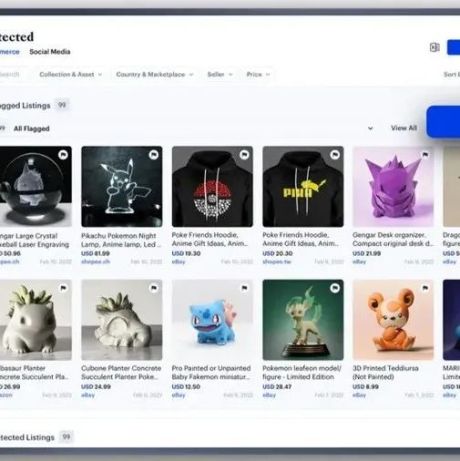

人工智能驱动的IP保护平台MarqVision近日宣布已完成2000万美元的A轮融资,用于为

快资讯2022-08-28

推荐资讯

推荐资讯