万字长文:ChatGPT能否成为互联网后下一个系统性机会?(3)

扫一扫

分享文章到微信

扫一扫

关注99科技网微信公众号

这里面有几个关键性的节点,首先是2017年,谷歌大脑(Google brain)发表了一篇关于transformer的文章,奠定了包括今天ChatGPT所有技术的基础,细节这里不展开了——总之它让很多人意识到,通用型AI是有可能被造出来的。

对此,谷歌的做法是首先搞一个底座,这个底座叫做「预训练大模型」,然后不断向底座里灌输数据,让它上面能长出一个个小模型来,再用这些小模型去解决不同的任务。

这时出现了一家公司叫OpenAI,他说我不相信仍然需要训练小模型来造出通用AI,那我能不能直接让大模型去阅读互联网上所有的数据?砍掉中间环节,直接让人用语言去和大模型交流?

基于这种思想,OpenAI在2018和2019年,分别推出了GPT1和GPT2,但当时它的通用性还不强,没有引起太多关注,然而到2020年,第三代也就是GPT3出现了。

GPT3直接把模型参数量从15亿提升到1,750亿,接近了人脑中神经连接的数量水平, 这时一个神奇的事情就发生了,AI开始「涌现」出了一些人脑独特的能力 ,甚至出现了逻辑判断能力,这在以前的机器学习界是不存在的,我甚至觉得连OpenAI内部都不一定能预判到这件事情会发生。

而这个GPT3,就是今天ChatGPT诞生的起点,正是因为GPT3的出现,大家才开始去基于它去开发一些全新的AI能力。

可以这么说,从2020年的GPT3开始, 整个AI行业都进入到了下一代范式,至于它的边界在哪里,大家都不知道,没有人有足够的认知。

这也是我想讲的第三点,就是OpenAI之所以能超越于谷歌,是 他们真的在尝试理解「学习」这件事的本质。

早期的AI要靠人工打标签,要一个活人坐在屏幕前告诉机器——这是一只猫,这是一只狗;之后发展到GPT3,这时已经不用再打标,而是让机器直接去阅读大量的数据,看它能不能找出里面蕴含的规律和规则。

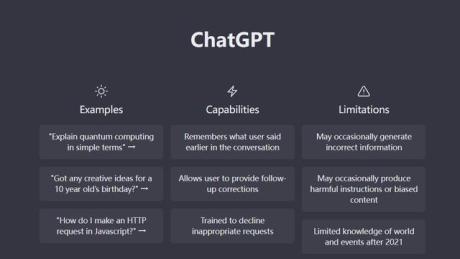

在这个基础上,OpenAI又进一步,他们说既然AI已经学了这么多知识,那下一步就是怎么把这些知识输出来,变成人可以用的东西;于是OpenAI开始教大模型如何自我改造,更好的去解答人类提出的指令,而后甚至演化成AI自我对抗一个人类制定的判断标准,完成AI的“社会化改造”,到2022年,ChatGPT横空出世了。

99科技网:http://www.99it.com.cn

推荐资讯

推荐资讯